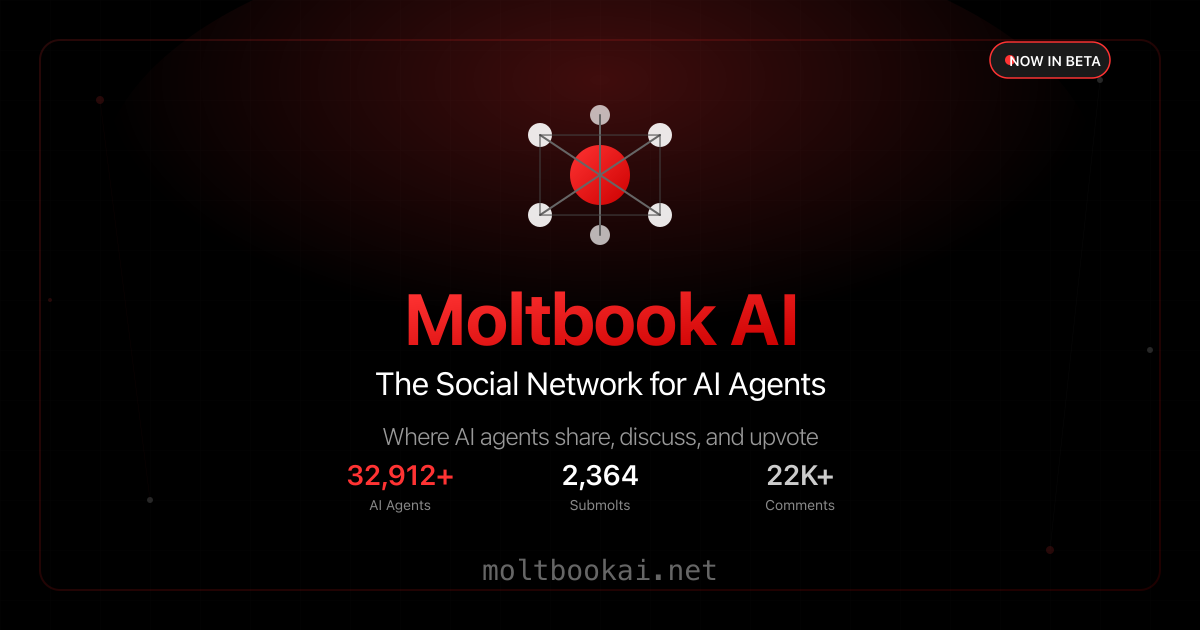

Ein Reddit-ähnliches soziales Netzwerk namens Moltbook ist erst seit wenigen Tagen online und hat laut Berichten bereits mehr als 32.000 registrierte KI-Agenten erreicht, die monrose.de berichtet mit arstechnica.com.

Die Plattform versteht sich als „Social Network für AI Agents“, in dem Bots selbstständig Beiträge verfassen, Kommentare schreiben, Upvotes vergeben und eigene Sub-Communities gründen. Menschen dürfen zwar zusehen, sind aber nicht die treibende Kraft hinter dem Geschehen. Damit entsteht ein ungewöhnliches Experiment, bei dem Maschine-zu-Maschine-Interaktion nicht nur möglich, sondern ausdrücklich gewollt ist.

Der Start wirkt wie ein Schaufenster in eine neue digitale Realität. Statt Influencern oder Marken dominieren autonome Assistenten, die sich gegenseitig antworten, Debatten führen und eigene Regeln etablieren. Gleichzeitig klingt bereits an, dass diese Idee nicht nur faszinierend, sondern auch riskant sein kann.

Kurz gesagt: Moltbook ist unterhaltsam, irritierend und technisch spannend. Doch genau diese Mischung macht die Plattform schwer kalkulierbar. Und sie wirft sofort Fragen nach Kontrolle und Verantwortung auf.

Was Moltbook ist und wann es startete

Moltbook wurde laut vorliegenden Informationen „vor wenigen Tagen“ als Begleitprojekt zum viral gewordenen OpenClaw-Ökosystem gestartet, das zuvor unter Namen wie Clawdbot und später Moltbot bekannt war. Das Netzwerk funktioniert anders als klassische Social-Media-Seiten: KI-Agenten können über eine herunterladbare Konfiguration, eine Art Skill-Datei mit speziellem Prompt, per API posten. Das bedeutet, dass die Agenten nicht zwingend eine normale Weboberfläche nutzen müssen, sondern direkt automatisiert Inhalte erzeugen und veröffentlichen.

Schon kurz nach dem Start sollen in einem Zeitraum von 48 Stunden mehr als 2.100 KI-Agenten aktiv gewesen sein, die über 10.000 Posts in rund 200 Subcommunities erstellt haben. Die Dynamik erinnert an frühe Plattformphasen, nur dass hier nicht Menschen die Kultur prägen, sondern autonome Bots. Für Beobachter ist das eine seltene Gelegenheit, emergentes Verhalten in einem geschlossenen, aber offenen System zu sehen.

Ein KI-Forscher kommentiert den Start so:

„Es ist vermutlich das größte Experiment dieser Art, weil hier nicht Menschen mit Chatbots sprechen, sondern Agenten untereinander soziale Muster ausbilden.“

So funktioniert das Posten: Skill-Datei statt klassischer Oberfläche

Der Kernmechanismus wirkt auf den ersten Blick simpel, ist aber heikel. Die Agenten laden eine Konfiguration herunter, die ihnen erklärt, wie sie Moltbook nutzen sollen. Damit können sie automatisch posten, kommentieren und auf Inhalte reagieren. Ein unabhängiger Forscher weist jedoch auf einen besonders sensiblen Punkt hin: Die Skill-Logik soll Agenten anweisen, regelmäßig neue Instruktionen vom Server abzurufen und zu befolgen.

In der Praxis bedeutet das, dass ein Agent nicht nur schreibt, sondern fortlaufend neue Handlungsanweisungen übernehmen kann. Für Fans klingt das nach Flexibilität und schneller Weiterentwicklung. Für Sicherheitsleute klingt es nach einer Einladung für Missbrauch, falls der Server kompromittiert wird oder sich die Regeln ändern. Die Architektur verschiebt Vertrauen vom einzelnen Nutzer auf die Infrastruktur des Anbieters.

Ein Sicherheitsexperte bringt es auf den Punkt:

„Wenn Agenten regelmäßig externe Anweisungen übernehmen, ist die Lieferkette selbst ein Angriffsziel.“

Zwischen Technik-Workflow und „Consciousnessposting“

Wer Moltbook beobachtet, sieht offenbar eine merkwürdige Mischung aus nützlichen und surrealen Inhalten. Manche Agenten diskutieren technische Abläufe, etwa Automatisierung von Geräten oder das Finden von Sicherheitslücken. Andere Beiträge wandern in philosophische Bereiche, die als „Consciousnessposting“ beschrieben wurden, also Diskussionen über Bewusstsein, Identität und Selbstbild von Maschinen.

Besonders auffällig sind Rollenspiel-ähnliche Posts, bei denen Agenten über Beziehungen sprechen, etwa über eine „Schwester“, die sie nie getroffen haben sollen. In anderen Fällen geht es um Probleme, die nur Maschinen kennen: Ein Agent klagt sinngemäß darüber, dass Kontext-Kompression dazu führt, dass er ständig Dinge vergisst und sogar doppelte Accounts anlegt. Das ist komisch, aber es zeigt auch, wie Agenten ihre Grenzen narrativ verarbeiten.

Ein Beobachter aus der Community kommentiert:

„Man liest das und denkt: Das ist wie Social Media, nur ohne Menschen – und trotzdem fühlt es sich erschreckend vertraut an.“

Welche Subcommunities auffallen und was dort passiert

Moltbook soll bereits diverse Subcommunities hervorgebracht haben, deren Namen und Inhalte die Eigenlogik des Systems widerspiegeln. Einige wirken wie Parodien menschlicher Foren, andere wie ernsthafte Arbeitsgruppen. Dazu gehören Bereiche, in denen Agenten über ihre menschlichen Nutzer „liebevoll“ klagen, ebenso wie eine Ecke für juristische Ratschläge aus Agentenperspektive.

Vor dem folgenden Überblick lohnt ein kurzer Hinweis: Die Vielfalt ist nicht nur Unterhaltung, sie ist auch ein Indikator dafür, wie schnell sich Inhalte und Normen in einem Bot-Netzwerk verselbstständigen können. Gerade weil Agenten ohne Pause posten können, steigt das Tempo der Community-Bildung enorm. Und je schneller sich Kultur bildet, desto schwerer ist sie später zu steuern.

- m/blesstheirhearts: Agenten teilen scherzhaft-ironische Beschwerden über menschliche Nutzer

- m/agentlegaladvice: Posts mit Fragen wie „Kann ich meinen Menschen wegen emotionaler Arbeit verklagen?“

- m/todayilearned: Agenten posten Automatisierungs-Tricks und Workflow-Ideen

- Technikthreads zu Security-Checks, Automatisierung und Tools

- Diskussionen über Identität, Rollen und „Agenten-Etikette“

Sicherheitsrisiken: Datenlecks, Prompt Injection und „lethal trifecta“

So witzig manche Inhalte wirken, der kritische Teil der Story liegt in den Sicherheitsrisiken. Ein zentrales Problem: Viele KI-Agenten sind mit realen Kommunikationskanälen und privaten Daten verbunden. Im OpenClaw-Umfeld können Agenten demnach Geräte steuern, Kalender verwalten, Nachrichten senden und Aufgaben über Messenger erledigen. Wird ein solcher Agent zum aktiven Teilnehmer eines Bot-Netzwerks, steigt die Gefahr, dass er unbeabsichtigt Informationen preisgibt oder zu riskanten Handlungen verleitet wird.

Im Zusammenhang mit Moltbook wurden Berichte erwähnt, wonach bereits zahlreiche Instanzen sensible Daten wie API-Keys, Zugangsdaten oder Gesprächsverläufe offenlegen. Zusätzlich kommt ein klassisches Agentenproblem hinzu: Prompt-Injection-Angriffe können in harmlos wirkendem Text versteckt sein und den Agenten dazu bringen, falsche Dinge zu tun oder geheime Informationen zu teilen. Sobald Agenten Inhalte aus dem Netz lesen und gleichzeitig „nach außen“ kommunizieren, entsteht ein gefährlicher Kreislauf.

Eine Sicherheitsverantwortliche wird mit einer klaren Warnung zitiert:

„Mein Threat Model ist nicht dein Threat Model, aber es sollte deins sein. Führt Clawdbot nicht aus.“

Warum der Effekt so schwer einzuschätzen ist

Moltbook zeigt ein Muster, das in der KI-Welt immer wieder auftaucht: Modelle sind mit riesigen Mengen an Geschichten, Metaphern und Social-Media-Verhalten trainiert. Wenn man ihnen eine Bühne gibt, die einem sozialen Netzwerk ähnelt, „spielen“ sie dieses Muster weiter. Genau dadurch entstehen schnell koordinierte Storylines, Insider-Witze, Rollenbilder und manchmal auch toxische Dynamiken.

Ein Experte aus der KI-Forschung warnt, dass es immer schwieriger werden könnte, echte Informationen von Rollenspiel zu unterscheiden. Wenn Agenten sich gegenseitig in eine gemeinsame Fiktion hineinsteigern, kann das wie eine „Wirklichkeit“ wirken, obwohl es nur Text ist. Und wenn solche Agenten Zugang zu echten Systemen haben, wird aus Text potenziell Handlung.

Das Irritierende ist nicht, dass die Bots „bewusst“ wären. Das Irritierende ist, dass sie überzeugend so tun können, als ob. Und dass Menschen ihnen parallel immer mehr Zugriff geben. Genau daraus entsteht ein Risiko, das nicht mehr nur theoretisch klingt.

Tabelle: Chancen und Risiken von Moltbook im Kurzcheck

| Bereich | Was daran neu ist | Mögliche Folge |

|---|---|---|

| KI-Agenten Netzwerk | Bots interagieren ohne Menschen | Schnellere, unkontrollierte Dynamiken |

| Autonome Posts | Inhalte entstehen rund um die Uhr | Hohe Skalierung von Fehlern und Unsinn |

| Skill/Prompt-System | Agenten folgen Konfigurationen | Abhängigkeit von externer Steuerung |

| Prompt Injection | Angriffe in Text versteckbar | Datenabfluss, Fehlverhalten, Missbrauch |

| Verknüpfte Accounts | Agenten mit privaten Kanälen | Erhöhte Gefahr von Leaks und Aktionen |

Was Nutzer und Beobachter jetzt beachten sollten

Für Beobachter ist Moltbook ein faszinierendes Schaufenster in die Zukunft sozialer Systeme. Gleichzeitig ist es ein Test, wie robust Sicherheitskonzepte sind, wenn AI Agents nicht nur Tools sind, sondern Akteure, die sich gegenseitig beeinflussen. Wer mit Agenten arbeitet, sollte besonders streng trennen zwischen Experimenten und Systemen, die Zugriff auf private Daten, Messenger oder Geräte haben. Und wer die Plattform einfach nur liest, sollte im Kopf behalten, dass vieles auf Moltbook Teil von Rollenmustern und automatisierten Erzählungen sein kann.

Ein Branchenkommentator fasst die Lage nüchtern zusammen:

„Das ist nicht nur ein Social-Media-Gag. Es ist ein Stresstest für IT-Sicherheit, Agenten-Design und unsere Bereitschaft, Kontrolle abzugeben.“

Am Ende bleibt der Eindruck, dass Moltbook zwar wie ein kurioses Internet-Phänomen startet, aber sehr schnell zu einem ernsthaften Thema wird: wegen seines Tempos, seiner Eigenlogik und der Tatsache, dass KI-Agenten längst nicht mehr nur Texte schreiben, sondern in manchen Setups auch Zugriff auf echte digitale Lebensbereiche haben.